Đánh giá

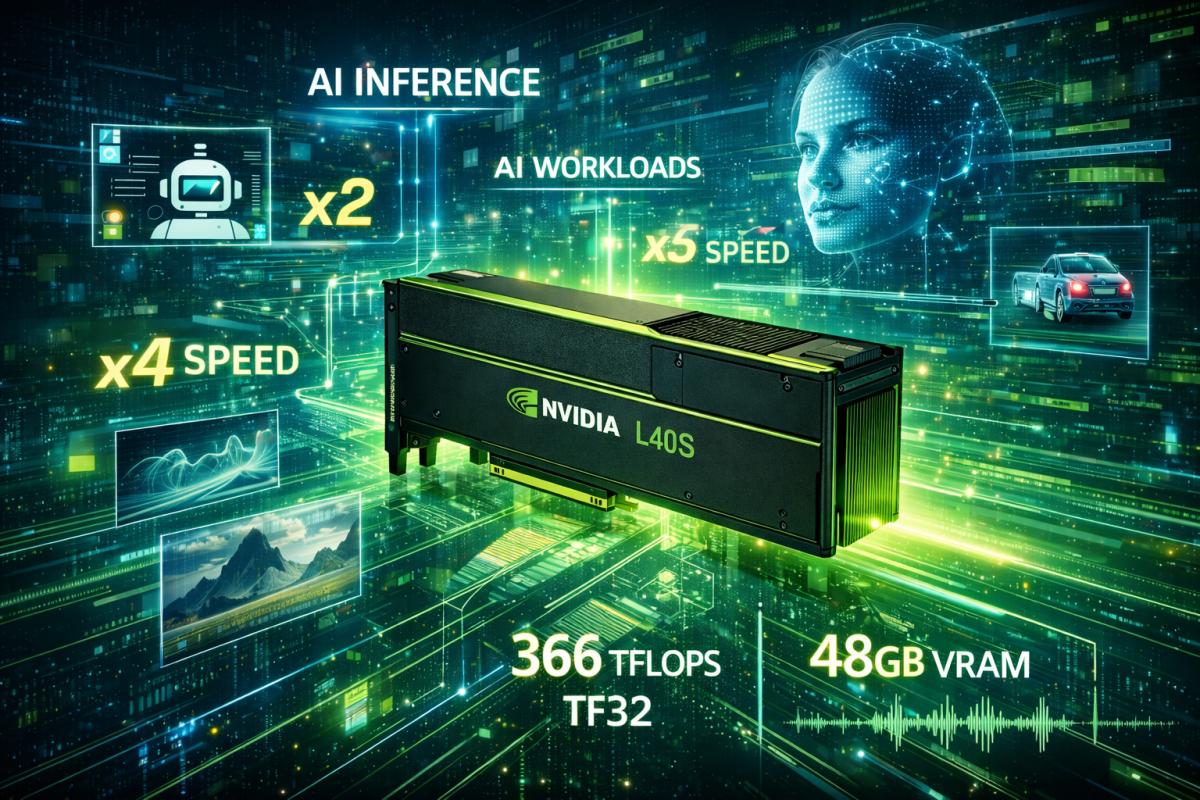

Đánh giá nhanh bộ xử lý đồ họa AI GPU chuyên dụng Nvidia L40S cho tác vụ AI cao cấp

GPU NVIDIA L40S – Giải Pháp AI & Generative AI Cho Doanh Nghiệp

NVIDIA L40S – GPU AI 48GB tối ưu cho AI on-premise, LLM và Inference

NVIDIA L40S là GPU trung tâm dữ liệu thế hệ mới dựa trên kiến trúc Ada Lovelace, được thiết kế chuyên biệt cho AI, Generative AI, LLM, Chatbot AI, Computer Vision và AI inference quy mô lớn.

Sản phẩm hiện đang được nhiều doanh nghiệp, trung tâm dữ liệu và đơn vị tích hợp hệ thống tại Việt Nam lựa chọn để triển khai AI thực tế.

Những tính năng ấn tượng của Nvidia L40s, vi xử lý AI GPU chuyên nghiệp.

GPU đa năng mạnh mẽ

Điểm nổi bật: Hiệu năng ấn tượng

Tensor Performance1,466 TFLOPS¹ |

RT Core Performance212 TFLOPS

|

Single-Precision Performance91.6 TFLOPS

|

Trang bị kiến trúc NVIDIA Ada Lovelace

NVIDIA L40S được xây dựng trên kiến trúc Ada Lovelace, thế hệ GPU mới nhất của NVIDIA dành cho data center và AI. Kiến trúc này mang lại:

-

Tensor Cores thế hệ 4 – tối ưu cho tính toán ma trận cần thiết trong Deep Learning.

-

Bộ nhớ lớn 48GB GDDR6 ECC với băng thông 864 GB/s – đủ sức chứa và xử lý các mô hình có kích thước đến hàng chục tỷ tham số.

Việc sử dụng Ada Lovelace thay vì Ampere hay các kiến trúc cũ giúp L40S có hiệu suất và tính linh hoạt cao hơn khi xử lý AI workloads chuyên sâu.

Bộ xử lý Tensor thế hệ thứ tư

Hiệu năng Tensor Core vượt trội – FP8 làm “trung tâm” cho AI

Tensor Cores là trái tim của GPU AI — và L40S có tới 568 nhân Tensor thế hệ 4, mang lại:

| Định dạng | Peak Tensor Throughput |

|---|---|

| FP32 | ~91.6 TFLOPS |

| TF32 | ~366 TFLOPS |

| FP16 / BF16 | ~733 TFLOPS |

| FP8 (quan trọng cho inference & training) | ~1,466 TFLOPS |

Vì sao FP8 quan trọng cho AI?

-

Precision thấp hơn (FP8) là chuẩn phổ biến khi chạy inference LLM và Generative AI, vì mô hình vẫn giữ chất lượng trong khi throughput tăng mạnh.

-

L40S có FP8 Tensor throughput ~1,466 TFLOPS, gần gấp đôi so với nhiều GPU đời trước (ví dụ A100 không hỗ trợ FP8 native).

-

Điều này giúp L40S xử lý các tác vụ như inference LLM, chat AI, xử lý text/ảnh/video hàng loạt nhanh hơn đáng kể.

Tensor Core thế hệ 4 với FP8/FP16 nâng cao trực tiếp tăng tốc các mô hình AI inference và fine-tuning mà vẫn tiết kiệm tài nguyên so với FP32.

Bộ xử lý RT thế hệ thứ ba

Bộ nhớ lớn & băng thông cao – phù hợp mô hình lớn

GPU AI để phục vụ SoTA LLM hoặc mô hình Vision/ML thường yêu cầu:

-

VRAM lớn để chứa mô hình, embedding vectors, và batch inputs.

-

Băng thông bộ nhớ cao để nhanh chóng truyền dữ liệu giữa VRAM và các nhân tính toán.

NVIDIA L40S có:

-

48 GB GDDR6 với ECC để đảm bảo cả độ chính xác lẫn dung lượng cho mô hình lớn.

-

Memory bandwidth ~864 GB/s, giúp duy trì throughput cao khi xử lý các batch lớn.

Với cấu hình này, GPU có khả năng xử lý cả:

-

Inference LLM lớn (7B, 13B class)

-

Generative AI multi-modal

-

Xử lý video / vision scale lớn

mà không dễ gặp bottleneck bộ nhớ như các GPU nhỏ hơn.

Lõi CUDA

Hiệu năng FP32 & TF32 – cho training và hybrid workloads

Trong các tác vụ training hoặc fine-tuning, GPU cần sức mạnh tính toán cả ở precision cao hơn:

-

FP32 TFLOPS ~91.6 – đủ mạnh để xử lý các workload không chỉ inference.

-

TF32 Tensor performance ~366 TFLOPS giúp tăng tốc các phép matrix multiply accumulate ở độ chính xác dùng trong training.

Điều này cho thấy L40S không chỉ là GPU inference — nó còn đáp ứng tốt các workload huấn luyện mô hình tầm trung.

Công cụ Transformer Engine

Hiệu quả và Bảo mật

Khả năng xử lý truyền dữ liệu và tích hợp trong hệ thống

GPU này dùng PCIe Gen4 x16 với băng thông hai chiều 64 GB/s — đủ để truyền dữ liệu nhanh giữa CPU ↔ GPU mà không hình thành bottleneck đáng kể đối với đa số workloads AI.

DLSS 3

Các yếu tố bổ sung hỗ trợ AI

Ngoài nhân tính toán, L40S còn nổi bật ở các tiện ích hỗ trợ workflow AI:

-

3× NVENC / 3× NVDEC với hỗ trợ AV1 – rất hữu ích cho các pipeline xử lý video, một phần của AI Generative hoặc multimedia AI.

-

Hỗ trợ vGPU virtualization – giúp chia tài nguyên cho nhiều instance inference trong môi trường production AI.

Vì sao doanh nghiệp nên chọn NVIDIA L40S?

Hiệu năng AI vượt trội

-

Tensor Core thế hệ 4, hỗ trợ FP8

-

Tăng tốc inference AI nhanh hơn A40 2–3 lần

-

Độ trễ thấp, xử lý đa người dùng

VRAM lớn 48GB

-

Chạy LLM, chatbot AI, mô hình CV lớn

-

Fine-tune mô hình AI nội bộ

-

Giảm chia mô hình, dễ triển khai

Tối ưu chi phí dài hạn

-

Thay thế cloud AI nước ngoài

-

Giảm chi phí thuê GPU theo giờ

-

Phù hợp AI on-premise tại Việt Nam

Phù hợp yêu cầu bảo mật & pháp lý

-

Dữ liệu lưu trữ nội bộ

-

Tuân thủ chính sách doanh nghiệp

-

Phù hợp ngân hàng, tài chính, sản xuất

Thông số kỹ thuật GPU NVIDIA L40S

| GPU Architecture | NVIDIA Ada Lovelace architecture |

| GPU Memory | 48GB GDDR6 with ECC |

| Memory Bandwidth | 864GB/s |

| Interconnect Interface | PCIe Gen4 x16: 64GB/s bidirectional |

| NVIDIA Ada Lovelace Architecture-Based CUDA® Cores | 18,176 |

| NVIDIA Third-Generation RT Cores | 142 |

| NVIDIA Fourth-Generation Tensor Cores | 568 |

| RT Core Performance TFLOPS | 212 |

| FP32 TFLOPS | 91.6 |

| TF32 Tensor Core TFLOPS | 183 I 366* |

| BFLOAT16 Tensor Core TFLOPS | 362.05 I 733* |

| FP16 Tensor Core | 362.05 I 733* |

| FP8 Tensor Core | 733 I 1,466* |

| Peak INT8 Tensor TOPS Peak INT4 Tensor TOPS |

733 I 1,466* 733 I 1,466* |

| Form Factor | 4.4″ (H) x 10.5″ (L), dual slot |

| Display Ports | 4x DisplayPort 1.4a |

| Max Power Consumption | 350W |

| Power Connector | 16-pin |

| Thermal | Passive |

| Virtual GPU (vGPU) Software Support | Yes |

| vGPU Profiles Supported | See virtual GPU licensing guide |

| NVENC I NVDEC | 3x l 3x (includes AV1 encode and decode) |

| Secure Boot With Root of Trust | Yes |

| NEBS Ready | Level 3 |

| Multi-Instance GPU (MIG) Support | No |

| NVIDIA® NVLink® Support | No |

|

*With Sparsity |

|

Những ứng dụng thực tế của NVIDIA L40S tại Việt Nam

Chatbot AI & LLM tiếng Việt

-

Chatbot chăm sóc khách hàng

-

Trợ lý AI nội bộ

-

AI tổng đài, AI CSKH

AI Camera & Computer Vision

-

CCTV AI

-

Nhận diện khuôn mặt, biển số

-

Giám sát nhà máy, khu công nghiệp

AI On-Premise & Private Cloud

-

AI nội bộ doanh nghiệp

-

Private AI Cloud

-

Hybrid AI Infrastructure

Render, VFX, Media

-

Render 3D

-

Encode/Decode video AV1

-

Media production

So sánh NVIDIA L40S và A40 (phổ biến tại Việt Nam)

| Tiêu chí | NVIDIA L40S | NVIDIA A40 |

|---|---|---|

| Kiến trúc | Ada Lovelace | Ampere |

| Generative AI | ⭐⭐⭐⭐⭐ | ⭐⭐ |

| Inference AI | Rất cao | Trung bình |

| Hiệu suất/Watt | Tốt | Thấp |

| Phù hợp dự án mới | ✅ | ❌ |

L40S là lựa chọn khuyến nghị cho dự án AI từ 2024 trở đi.

NVIDIA L40S phù hợp với ứng dụng nào?

-

Doanh nghiệp triển khai AI nội bộ

-

Công ty phần mềm, AI startup

-

Ngân hàng, bảo hiểm, tài chính

-

Nhà máy, khu công nghiệp

-

Trung tâm dữ liệu, IDC

-

Đơn vị SI, MSP

Dịch vụ cung cấp đi kèm

- GPU NVIDIA L40S chính hãng

- Tư vấn cấu hình server AI

- Lắp đặt, triển khai tại Việt Nam

- Hỗ trợ kỹ thuật, bảo hành chính hãng

- Tối ưu AI inference & LLM

Báo giá GPU NVIDIA L40S tại Việt Nam

Hiện các dòng GPU AI đang có nhu cầu lớn trên phạm vi toàn cầu, giá cả thay đổi liên tục. Để có báo giá tốt nhất và chính xác nhất, vui lòng liên hệ với đội ngũ kinh doanh của Pacotech Co. Ltd. Giá GPU NVIDIA L40S phụ thuộc số lượng, cấu hình server và thời điểm nhập khẩu.

Liên hệ tư vấn & báo giá Pacotech Co. Ltd, email: info@pacotech.vn hoặc số điện thoại 024.668.26.368

-

Tư vấn GPU AI cho doanh nghiệp

-

Báo giá NVIDIA L40S

-

Giải pháp AI on-premise trọn gói